대화의 길

X

교수

새로운 세상을

꿈꾸게 한 학문의 융합

박진호 국어국문학과 교수

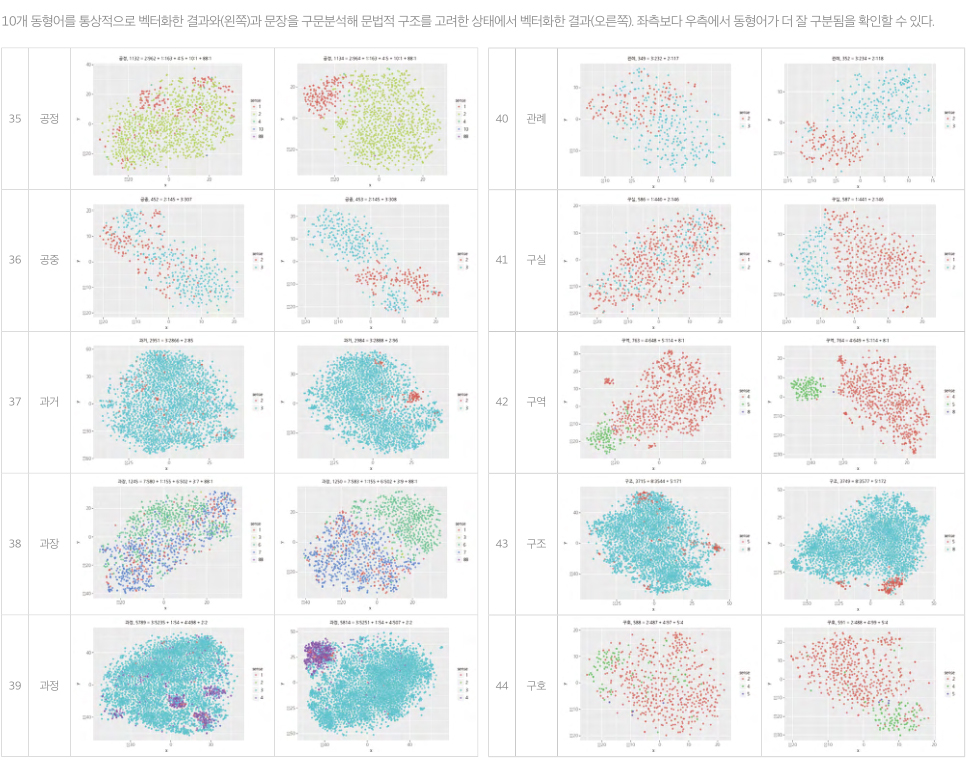

대량의 데이터를 입력하기만 하면 신경망이 알아서 학습하는 딥러닝 기술은 음성 인식, 기계 번역 같은 AI 언어모델 개발에서 언어학자들의 역할을 축소 시켰다. 박진호 교수는 AI 언어모델 개발이 규모 경쟁에 돌입한 현재, 언어학자의 도메인 지식을 활용하면 비용을 줄이고 신경망 학습 시간을 단축하는 효율적인 개발이 가능하다고 말한다. 이를 증명하기 위해 그는 지난 2018년 한국어학자로서 최초로 AI 개발에 뛰어들어 딥러닝 기반 한국어 형태소 분석기를 만들어냈다. 학문 간 장벽을 허물며 유용한 AI 기술 개발에 앞장서고 있는 박진호 교수를 만났다.

1.

인공지능 기술의 대표적인 활용 분야인 ‘자연어 처리’란 무엇인가요?

자연어 처리(NLP: Natural Language Processing)는 우리가 일상생활에서 사용하는 언어인 자연어의 의미를 분석해 컴퓨터가 처리할 수 있도록 하는 일입니다. 음성 인식, 번역, 챗봇, 스팸 메일 분류 등 이미 폭넓게 사용되고 있어요. 자연어 처리를 위해서는 텍스트를 컴퓨터가 이해할 수 있도록 하는 작업이 필요한데 2017년부터 ‘트랜스포머’라는 신경망 모델이 이를 주도하고 있습니다. ‘트랜스포머’ 모델의 가장 큰 특징은 ‘어텐션 메커니즘(Attention Mechanism)’을 활용한다는 점이에요. 만약 5개 단어로 이뤄진 문장이 있을 때 단어들 사이의 관계가 가까우면 높은 어텐션 점수를, 멀면 낮은 점수를 부여하는 방식으로 문장의 맥락과 의미를 학습하는 신경망입니다.

2.

언어학자의 도메인 지식이 AI 언어모델 개발에서 어떻게 활용될 수 있나요?

어텐션 메커니즘의 경우 앞서 설명한 방법으로 학습한 뒤, 문장을 생성할 때 첫 번째 단어를 만들고 그 단어와 가장 관련성 높은 두 번째 단어를 생성하고, 또 두 단어를 바탕으로 자연스럽게 이어질 수 있는 세 번째 단어를 생성하는 식으로 작동합니다. 그런데 이 원리에 부합하지 않는 문장들이 있어요. 가령 ‘The girl loved by many boys is my sister’라는 문장은 동사인 is 바로 앞에 boys가 있지만 한참 앞에 있는 girl을 설명하고 있죠. 어텐션 메커니즘은 다음 단어를 예측하기 위해 처음의 파라미터1)값을 랜덤하게 초기화합니다. 그러다 보니 신경망 학습으로 가장 연관성이 큰 단어가 높은 어텐션 점수를 받기까지 오랜 시간이 걸리고 정확한 분석을 위해 투입해야 할 데이터도 방대해지면서 많은 양의 에너지가 필요해요. 하지만 언어학자들이 문장 분석을 거치면 이러한 특수사항을 금방 알 수 있어요. 왜냐하면 어텐션 메커니즘은 문장의 구성 성분을 분해하고 관계를 분석하는 언어학의 ‘구문 분석’과 무척 유사하기 때문입니다. 파라미터값을 초기화하지 말고 언어학자들과 논의해 정답에 가까운 값으로 초깃값을 준다면 신경망 학습에 들이는 시간과 AI를 개발하는 데 드는 천문학적인 비용을 크게 줄일 수 있어요.

파라미터(parameter, 매개변수): 함수를 호출할 때 인수로 전달된 값을 함수 내부에서 사용할 수 있게 해주는 변수. 소프트웨어나 시스템상의 작동에 영향을 미치며, 외부로부터 투입되는 데이터로 이해할 수 있다.

3.

한국어에 특화된 AI 언어모델이 필요한 이유는 무엇인가요?

AI 사업을 미국 회사들이 주도하다 보니 다른 나라들은 그 회사에서 나온 AI 모델을 가져와 조금씩 수정해 사용하고 있어요. 언어모델도 마찬가지이죠. 하지만 전 세계에는 약 7,000개의 언어가 있고 언어마다 특색과 차이가 존재합니다. 영어를 기반으로 만든 알고리즘이 다른 언어에 꼭 맞게 쓰이는 것은 불가능해요. 90%만의 정확도를 가진 모델을 문제없이 사용하는 사람도 있지만 높은 정확도를 가진 모델이 꼭 필요한 사람들도 존재합니다. 한국어의 특징을 감안해 100%에 가까운 성능을 지닌 언어모델을 만드는 데 한국어학자와 공학자가 함께 노력해야 해요.

4.

교수님께서는 20년 전부터 소프트웨어 연구를 시작하셨습니다.

AI 공부도 이어가고 계신 데 기억에 남는 일이 있나요?

1999년에 디지털 시대를 앞두고 한국어의 말뭉치와 전자사전 등을 구축하는 국어 정보화 사업에 참여했어요. 프로그램을 만드는 데 언어학자의 역할이 컸지만, 언어학자는 프로그래밍을, 프로그래머는 언어학을 모르니 제대로 소통할 수 없었죠. C언어, C++과 같은 프로그래밍 언어를 독학하니 개발자들과 소통하기도 편했고 재밌었습니다. AI 공부를 시작한 것은 2018년부터인데 모든 컴퓨터 사이언스 분야를 공부한다기보단, ‘유용한 프로그램 하나만 만들자’라는 생각으로 접근했어요. 당시에 『석보상절』, 『월인석보』 같은 중세 문헌들이 전산화되었는데 검색 기능이 제대로 작동되지 않아 불편한 점이 많았습니다. 그래서 키워드를 검색하면 그 단어가 어떤 문헌 어디에 등장하는지 확인할 수 있는 프로그램을 만들어 주변 교수님들과 선후배들에게 배포했어요. 해결되지 않는 오류가 발생하면 잠도 못 잘 만큼 신경 쓰는 일도 많았지만, 주변에서 논문 쓰는 시간이 10배 단축되었다고 무척 좋아해 주셔서 보람이 컸습니다.

5.

학문 간 장벽을 허물고 융합하는 공부를 위해 필요한 것은 무엇일까요?

언어학과 프로그래밍을 비교한다면 언어학은 다른 인문학에 비해 딱 떨어지는 규칙이 정해져 있다는 점에서 수학과 비슷한 성질이 있어요. ‘언어’를 다룬다는 점도 같고요. 하지만 여전히 프로그래밍 수업을 어려워하는 학생들이 많습니다. 저는 제가 그랬던 것처럼 다른 분야 학문을 접할 때 깊고, 넓게 공부한다는 생각보다 단순하더라도 명확한 목표를 잡고 접근했으면 좋겠어요. 그 과정 자체가 공부의 동기 부여도 주고 보람도 느낄 수 있기 때문입니다. 다행히 과거와 달리 학생들이 전공 외의 공부도 접하기 위해 노력하고 있어요. 저 역시 학생들이 흥미를 갖고 공부할 수 있도록 더 쉽고 재밌게 가르치는 노하우를 개발해야 할 것입니다.

6.

앞으로의 연구 계획에 대해 한 말씀 부탁드립니다.

자연어 처리 연구에 언어학자들의 도움이 필요하다고 느끼려면 그러한 언어학적 지식이 AI 언어모델 성능을 확실히 향상한다는 것을 증명해야 합니다. 딥러닝 기반 한국어 형태소 분석기를 개발해냈지만, 자연어 처리라는 넓은 세계에서 형태소 분석기는 작은 일부에 불과해요. 언어학자로서 한국어의 특징과 개별성을 담은 AI 언어모델을 개발하는 데 일조하고 그런 연구를 함께할 수 있는 인재들을 길러내는 데에도 최선을 다하려고 합니다.